Si chiama Giove, ma non è né un pianeta né una divinità; stando, però, ai suoi sviluppatori, avrà poteri non umani.

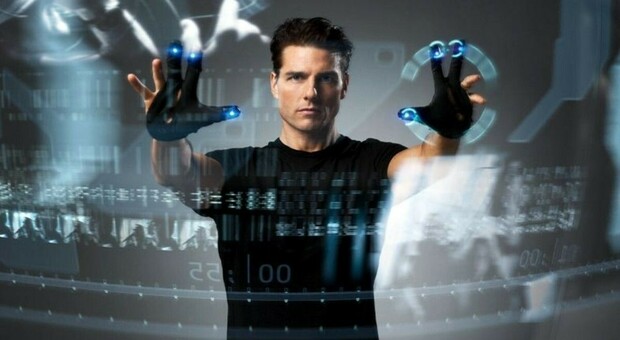

Giove è infatti il nuovo sistema di polizia predittiva, basato sull’intelligenza artificiale a cui sta lavorando il Dipartimento di pubblica sicurezza del ministero dell’Interno. Una sorta di pre-crimine in pieno stile Minority Report, la profetica Novella pubblicata da Philip K. Dick nel lontano 1956 e diventata poi un blockbuster con Tom Cruise nel 2002. E, proprio come i celebri “Precog” della storia, Giove avrà il compito di prevenire (e reprimere?) i reati a più alto impatto sociale. Ma facciamo un passo indietro. Giove nasce nel 2020 nel Dipartimento di pubblica sicurezza del ministero dell’Interno. L’idea da cui prende le mosse, al netto della fantascienza di Dick, richiama da vicino un software creato nel 2008 nella Questura di Milano, KeyCrime, che aveva il compito di stilare una previsione statistica delle possibili rapine in ambito commerciale, in particolare negozi e farmacie, analizzando migliaia di dati relativi a reati già commessi (luogo, tipologia di crimine, periodo, orario, target).

LA PREVISIONE

Rispetto a questo schema, Giove, ufficialmente definito “sistema di elaborazione e analisi automatizzata per l’ausilio alle attività di polizia” dovrebbe compiere un ulteriore salto di qualità riuscendo a predire dove e quando saranno commessi determinati crimini. Ma come farà a generare le sue profezie? Semplice: attingendo alle banche dati delle forze dell’ordine e proponendosi come supporto tecnico che, attraverso l’analisi delle denunce raccolte, potrà dire dove e come dislocare gli agenti o quali aree e quali orari coprire per garantire maggiore sicurezza. Nel radar dell’algoritmo non ci saranno però soltanto le rapine in ambito commerciale ma una rosa più ampia di reati quali furti in casa, truffe e persino violenze sessuali. Eppure, quella che sulla carta può sembrare una bella notizia e una nuova frontiera della sicurezza, rischia di rivelarsi un’arma a doppio taglio (e non soltanto per gli enormi risvolti etici già evidenziati in Minority Report). Il punto è che l’utilizzo dell’AI potrebbe non essere neutrale e unbiased. Non è un caso che in questi ultimi tempi siano già emersi numerosi casi che dimostrano di quanti stereotipi e di quante discriminazioni sia infarcita l’Intelligenza Artificiale. E così, mentre il Dipartimento di pubblica sicurezza del Ministero vorrebbe iniziare a dotare le stazioni di polizia italiane di questo nuovo sistema, ci sono una serie di aspetti che stanno ritardando e frenando l’operazione. Operazione i cui intenti rischiano di essere annacquati da una certa inaffidabilità di base e dai rischi di un approccio discriminatorio. Ma non solo. C’è anche un rilevante tema di privacy di cui tenere conto.

LA VALUTAZIONE

Per questo, prima di diventare operativo Giove dovrà essere sottoposto al vaglio del Garante della privacy. E il “documento di valutazione dell’impatto” dovrà sciogliere i nodi relativi alla tutela della privacy e della libertà personale. Tenendo anche conto che fino a oggi gli strumenti di polizia predittiva già utilizzati in altre parti del mondo sono finiti sotto accusa proprio perché l’algoritmo sembrava riproporre stereotipi e alimentare discriminazioni. Che il tema sia complesso e, al tempo stesso, attualissimo è indubbio. Anche il Parlamento europeo ha recentemente discusso di polizia predittiva e presto dovrebbe approvare l’AI act (la prima legge al mondo dedicata all’intelligenza artificiale) che interverrà su questa materia. La sicurezza è senz’altro importante, ma bisogna decidere che prezzo siamo disposti a pagare per sentirci più sicuri. E allora il rischio di ritrovarci protagonisti di una deformazione distopica non è un rischio accettabile. Perché una cosa è certa e non occorre l’AI per stabilirlo: un mondo più sicuro non può essere barattato con un mondo più inquietante.

© RIPRODUZIONE RISERVATA